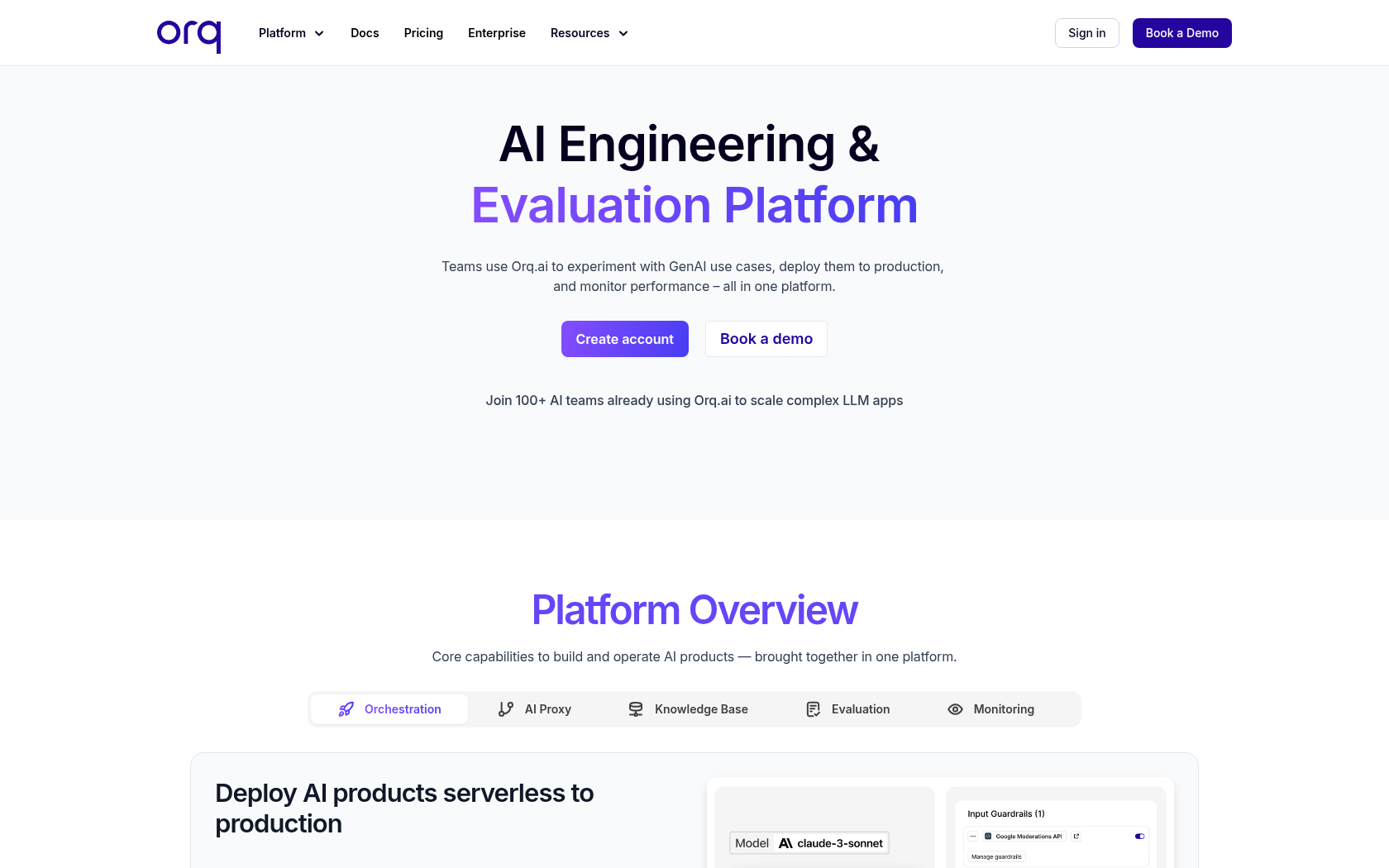

Orq.ai

Orq.ai(오크.ai)는 프롬프트 설계부터 모델 평가, 배포, 모니터링까지 LLM 운영 전 과정을 통합 관리하며, 협업과 보안을 강화한 차세대 생성형 AI 플랫폼입니다.

- 출시일

- 2024년

- 월간 방문자 수

- 9.8천

- 개발국

- 네덜란드

- 플랫폼

- 웹

- 언어

- 영어

키워드

- LLMOps 플랫폼

- AI 운영 관리

- AI 배포 자동화

- 프롬프트 관리

- 모델 오케스트레이션

- RAG 파이프라인

- AI 거버넌스

- SOC2 인증

- 생성형 AI 플랫폼

- LLM 실험 도구

- 프롬프트 버전 관리

- AI 협업 도구

- LLM 평가 자동화

- 데이터 프라이버시

- 온프레미스 AI

플랫폼 설명

Orq.ai(오크.ai)는 대규모 언어 모델을 활용해 AI 애플리케이션과 에이전트를 개발, 배포, 운영할 수 있도록 지원하는 협업형 생성형 AI 플랫폼입니다. 이 플랫폼은 언어 모델 운영 전 과정을 하나의 통합 환경에서 관리하도록 설계되어 있으며, 프롬프트 설계, 모델 실험, 성능 평가, 배포 및 모니터링을 모두 포함합니다. 사용자는 OpenAI, Anthropic, Mistral 등 다양한 AI 모델을 통합해 실험할 수 있으며, 코드 수정 없이 모델을 전환하거나 조합하여 최적의 성능을 빠르게 도출할 수 있습니다.

Orq.ai의 핵심은 효율적인 프롬프트 관리와 자동화된 실험 환경입니다. 개발자와 기획자는 시각화된 인터페이스에서 프롬프트 버전을 관리하고, 실험 결과를 비교하며 성능을 정량적으로 평가할 수 있습니다. 또한 검색 보강 생성 기능과 출력 제어 규칙 설정을 통해 모델의 응답 품질과 신뢰도를 높일 수 있습니다. 이런 구조는 반복적인 AI 실험 과정을 간소화하며, 제품 개발 속도를 크게 향상시킵니다.

보안과 데이터 관리 측면에서도 기업 환경에 최적화되어 있습니다. Orq.ai는 SOC 2 인증과 GDPR 준수를 기반으로 하며, 데이터 거주지 선택, 역할 기반 접근 제어, 온프레미스 또는 VPC 배포 옵션을 제공합니다. 이를 통해 금융, 헬스케어, 공공기관 등 보안이 중요한 산업에서도 안전하게 사용할 수 있는 신뢰성 높은 AI 플랫폼으로 평가받고 있습니다.

핵심 기능

-

프롬프트 관리

프롬프트를 버전별로 저장, 수정, 재사용할 수 있는 중앙화 관리 기능

-

모델 게이트웨이

다양한 LLM API를 연결해 모델 라우팅 및 자동 대체 수행

-

RAG 파이프라인 관리

검색 보강형 생성 파이프라인 구성 및 시각화 관리

-

실험 및 평가 엔진

프롬프트와 모델 조합별 성능 비교 및 자동 점수화

-

오케스트레이션 관리

모델 호출, 리트라이, 폴백을 제어하는 파이프라인 자동화

-

보안 및 거버넌스 제어

권한, 데이터 마스킹, 감사 로그 관리 기능 제공

-

모니터링 대시보드

AI 응답 품질, 비용, 오류율, 지연 시간 등의 실시간 분석

-

SDK 및 API 통합

개발 환경 내 직접 통합 가능한 Python·Node SDK 지원

활용 사례

- 프롬프트 실험

- LLM 성능 비교

- 모델 버전 관리

- AI 에이전트 배포

- RAG 구성

- 프롬프트 최적화

- Guardrails 설정

- 모델 평가 자동화

- A/B 테스트

- 비용 모니터링

- 프라이버시 보호

- 거버넌스 관리

- 온프레미스 운영

- 협업형 AI 개발

- 다중 모델 관리

사용 방법

워크스페이스 설정

모델 활성화

배포 구성

SDK 호출 및 모니터링

요금제

| 요금제 | 가격 | 주요 기능 |

|---|---|---|

| Free | €0 | • 1,000 로그 저장 (제한 있음) • 1명 사용자 • 분당 100 API 호출 가능 • 로그 및 트레이스 3일 보관 • 50MB 스토리지 제공 • 통합 모델 API 제공 • 프롬프트 엔지니어링 기능 • 평가자 라이브러리 • 실시간 로그 모니터링 • 대시보드 제공 • 커뮤니티 지원 센터 • 이메일 지원 |

| Pro | €250/월 | • Free 요금제 기능 포함 • 25,000 로그 저장 • 5명 사용자 • 분당 1,500 API 호출 가능 • 2.5GB 스토리지 제공 • 로그 및 트레이스 30일 보관 • 무제한 웹훅 지원 • 표준 SLA • Slack / Teams 고객 지원 |

| Enterprise | 문의 | • Pro 요금제 기능 포함 • 맞춤형 로그 및 트레이스 설정 • 사용자 지정 호출 속도 제한 • 확장형 커스텀 스토리지 • 문서 처리 우선순위 지원 • 역할 기반 접근 제어 • AWS 및 Azure 마켓플레이스 배포 지원 • VPC 내부 또는 온프레미스 배포 옵션 제공 • 솔루션 엔지니어 기술 지원 • 엔터프라이즈 SLA 제공 |

자주 묻는 질문

-

Orq.ai는 소프트웨어 팀이 대규모 언어 모델(LLM) 애플리케이션을 구축, 출시, 최적화할 수 있도록 지원하는 생성형 AI 협업 플랫폼입니다.

-

로그는 하나의 대규모 언어 모델 호출 과정에서 발생한 입력값, 출력값, 그리고 상호작용의 메타데이터를 기록한 데이터를 의미합니다. 즉, AI 모델이 어떤 요청을 받고 어떤 결과를 반환했는지를 추적할 수 있는 기록입니다.

-

로그는 사용자의 애플리케이션이 Orq.ai를 통해 LLM과 상호작용할 때마다 자동으로 생성됩니다. 다음과 같은 항목이 포함됩니다.

• 애플리케이션이 Orq.ai를 통해 LLM에 요청을 보낼 때마다 생성되는 호출 기록

• 사용자의 인프라에서 전송된 외부 로그

• 사용자나 팀이 제출한 피드백 데이터

• 평가 도구 또는 자동화된 테스트 결과와 판단 로그 -

모든 데이터는 Google Cloud Platform의 고도 보안 데이터 센터에 암호화되어 저장됩니다. Orq.ai는 업계 최고 수준의 보안 표준과 규정 준수를 따르며, 모든 코드 저장소와 서버 이미지는 지속적으로 취약점 검사를 거칩니다.

또한 SOC 2 인증은 Vanta Security Operations Center Platform을 통해 관리되며, 개인 정보는 최소한으로 저장되며 필요 시 즉시 삭제되도록 설정할 수 있습니다. -

Orq.ai는 SOC 2 인증과 유럽 일반 데이터 보호 규정을 준수하며, EU 인공지능법 기준에도 부합하는 안전한 AI 플랫폼입니다. 이러한 보안 체계는 팀이 데이터를 안전하게 관리하면서도 규정을 충족하도록 돕습니다.

-

Orq.ai는 클라우드, VPC, 온프레미스 등 다양한 배포 환경을 지원합니다. 조직의 보안 정책과 인프라 요구사항에 따라 자율적으로 모델 호스팅 환경을 선택할 수 있습니다.

-

Orq.ai는 전체 LLM 운영 자동화 라이프사이클을 아우르는 플랫폼으로, AI 에이전트의 설계, 배포, 모니터링, 성능 최적화까지 통합 관리합니다. 또한 Langfuse나 LangSmith가 주로 “관찰”에 초점을 맞춘 반면, Orq.ai는 엔드 투 엔드 AI 시스템 구축 및 운영에 특화된 구조로 설계되어 있습니다.

-

Orq.ai Studio는 팀이 LLM 운영 자동화의 핵심 워크플로우를 처리할 수 있도록 지원하는 강력한 도구입니다. 이를 통해 모델 학습, 평가, 배포, 모니터링 등 생성형 AI 전 과정을 한 곳에서 제어할 수 있습니다.

⚠ 제공된 전체 정보 중 오류가 있거나 보충이 필요하다면, 버튼을 눌러 알려주세요. 빠르게 검토 후 반영하겠습니다!