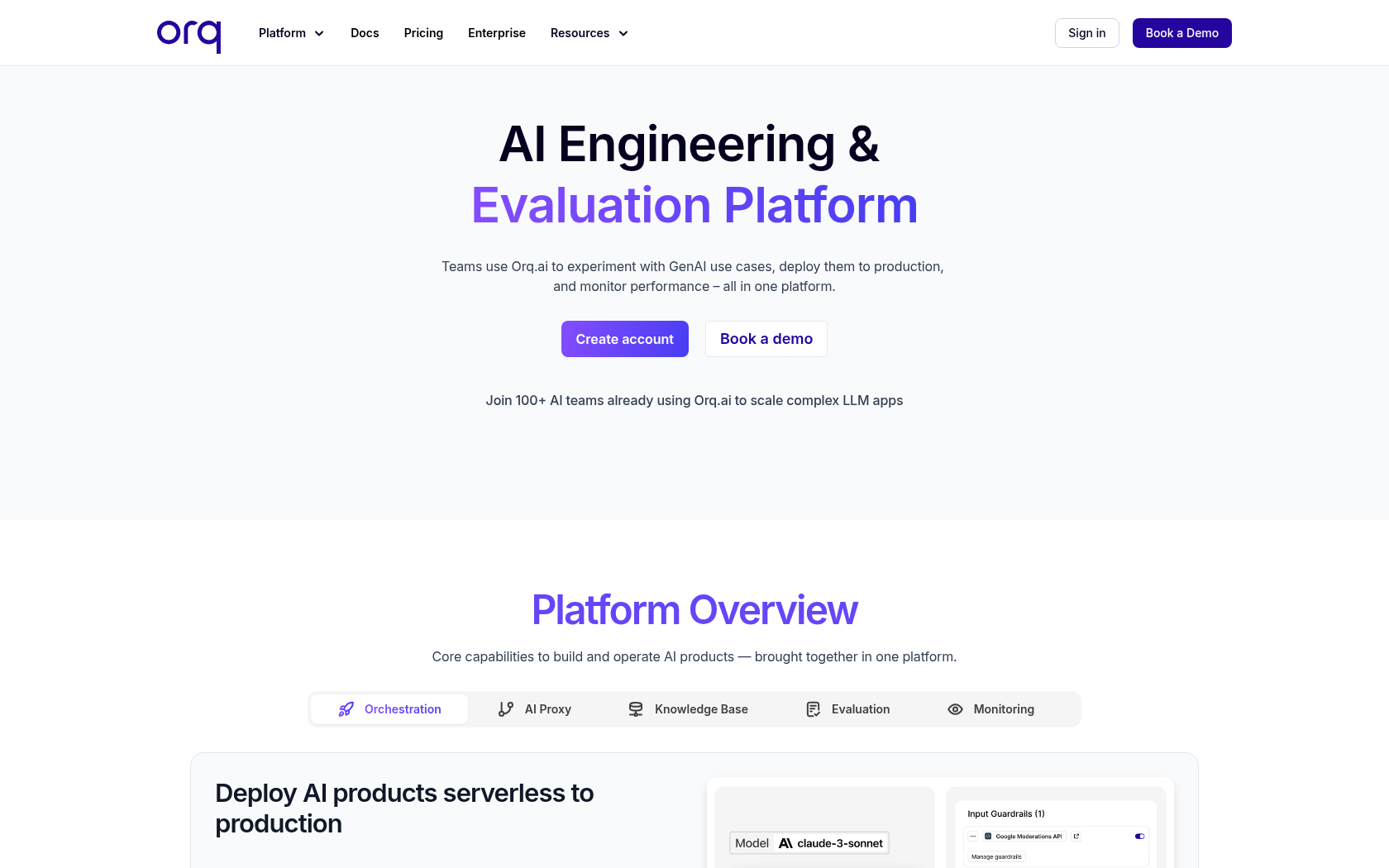

Orq.ai

Orq.ai(オークai)は、プロンプト設計からモデル評価、配布、モニタリングまで、LLM運営の全過程を統合管理し、コラボレーションとセキュリティを強化した次世代生成型AIプラットフォームです。

- リリース日

- 2024年

- 月間訪問者数

- 9800

- 開発国

- オランダ

- プラットフォーム

- ウェブ

- 言語

- 英語

キーワード

- LLMOpsプラットフォーム

- AI運用管理

- AIデプロイメント自動化

- プロンプト管理

- モデルオーケストレーション

- RAGパイプライン

- AIガバナンス

- SOC2認証

- 生成型AIプラットフォーム

- LLM実験ツール

- プロンプトバージョン管理

- AIコラボレーションツール

- LLM評価自動化

- データプライバシー

- オンプレミスAI

プラットフォームの説明

Orq.ai(オークai)は、大規模な言語モデルを活用してAIアプリケーションとエージェントを開発、配布、運営できるように支援する協業型生成型AIプラットフォームです。 このプラットフォームは、言語モデル運営の全過程を一つの統合環境で管理するように設計されており、プロンプト設計、モデル実験、性能評価、配布、モニタリングをすべて含みます。ユーザーは、OpenAI、Anthropic、Mistralなどの様々なAIモデルを統合して実験することができ、コードを修正することなく、モデルを切り替えたり、組み合わせたりして、最適なパフォーマンスを迅速に導き出すことができます。

Orq.aiの核心は効率的なプロンプト管理と自動化された実験環境です。開発者とプランナーは、視覚化されたインターフェースでプロンプトのバージョンを管理し、実験結果を比較し、パフォーマンスを定量的に評価することができます。 また、検索強化生成機能と出力制御ルール設定により、モデルの応答品質と信頼性を高めることができます。このような構造は、反復的なAI実験プロセスを簡素化し、製品開発のスピードを大幅に向上させます。

セキュリティとデータ管理の面でも企業環境に最適化されています。Orq.aiはSOC 2認証とGDPR準拠に基づいており、データ居住地の選択、役割ベースのアクセス制御、オンプレミスまたはVPC展開のオプションを提供します。これにより、金融、ヘルスケア、公共機関など、セキュリティが重要な産業でも安全に使用できる信頼性の高いAIプラットフォームとして評価されています。

コア機能

-

プロンプト管理

プロンプトをバージョンごとに保存、修正、再使用できる集中管理機能

-

モデルゲートウェイ

様々なLLM APIを接続し、モデルのルーティングと自動置換を実行します。

-

RAGパイプライン管理

検索強化型生成パイプラインの構成と可視化管理

-

実験・評価エンジン

プロンプトとモデルの組み合わせによる性能比較と自動採点化

-

オーケストレーション管理

モデル呼び出し、リトライ、フォールバックを制御するパイプラインの自動化

-

セキュリティとガバナンス管理

権限、データマスキング、監査ログ管理機能を提供します。

-

モニタリングダッシュボード

AIの応答品質、コスト、エラー率、遅延時間などのリアルタイム分析

-

SDKとAPIの統合

開発環境内で直接統合可能なPython-Node SDKのサポート

活用事例

- プロンプト実験

- LLMの性能比較

- モデルバージョン管理

- AIエージェントの展開

- RAG構成

- プロンプトの最適化

- ガードレール設定

- モデル評価の自動化

- A/Bテスト

- コストモニタリング

- プライバシー保護

- ガバナンス管理

- オンプレミス運用

- 協調型AI開発

- マルチモデル管理

使用方法

ワークスペース設定

モデルの有効化

配布構成

SDK呼び出しとモニタリング

料金プラン

| 料金プラン | 価格 | 主な特徴 |

|---|---|---|

| Free | €0 | • 1,000個のログを保存(制限あり) • 1ユーザー • 毎分100回のAPI呼び出しが可能 • ログとトレースを3日間保管 • 50MBストレージ提供 • 統合モデルAPIを提供 • プロンプトエンジニアリング機能 • 評価者ライブラリ • リアルタイムログモニタリング • ダッシュボード提供 • コミュニティサポートセンター • メールサポート |

| Pro | €250/月 | • Freeプラン機能付き • 25,000ログ保存 • 5人のユーザー • 毎分1,500回のAPI呼び出しが可能 • 2.5GBストレージ提供 • ログとトレースを30日間保管 • 無制限のウェブフックをサポート • 標準SLA • Slack / Teamsカスタマーサポート |

| Enterprise | 問い合わせ | • Proプランに含まれる機能 • カスタムログとトレース設定 • カスタム呼び出し速度制限 • 拡張可能なカスタムストレージ • ドキュメント処理優先順位のサポート • ロールベースのアクセス制御 • AWSおよびAzureマーケットプレイスへのデプロイをサポート • VPC内またはオンプレミス展開のオプション提供 • ソリューションエンジニアの技術サポート • エンタープライズSLAの提供 |

よくあるご質問

-

Orq.aiは、ソフトウェアチームが大規模な言語モデル(LLM)アプリケーションを構築、リリース、最適化するための生成型AIコラボレーションプラットフォームです。

-

ログとは、一つの大規模な言語モデルの呼び出し過程で発生した入力値、出力値、そしてインタラクションのメタデータを記録したデータを意味します。 つまり、AIモデルがどのような要求を受け、どのような結果を返したかを追跡できる記録です。

-

ログは、ユーザーのアプリケーションがOrq.aiを介してLLMと対話するたびに自動的に生成されます。以下の項目が含まれます。

- アプリケーションがOrq.ai経由でLLMにリクエストを送信するたびに生成される呼び出しログ。

- ユーザーのインフラストラクチャから送信された外部ログ

- ユーザーまたはチームから送信されたフィードバックデータ

- 評価ツールまたは自動化されたテスト結果および判定ログ -

すべてのデータは、Google Cloud Platformの高セキュリティのデータセンターに暗号化されて保存されます。Orq.aiは業界最高水準のセキュリティ基準とコンプライアンスを遵守し、すべてのコードリポジトリとサーバーイメージは継続的に脆弱性チェックを受けます。

また、SOC 2認証はVanta Security Operations Center Platformを通じて管理され、個人情報は最小限で保存され、必要に応じてすぐに削除できるように設定することができます。 -

Orq.aiは、SOC 2認証と欧州一般データ保護規則に準拠し、EU人工知能法の基準にも準拠した安全なAIプラットフォームです。 これらのセキュリティ体制は、チームがデータを安全に管理しながら規制を満たすのに役立ちます。

-

Orq.aiは、クラウド、VPC、オンプレミスなど多様な展開環境をサポートします。組織のセキュリティポリシーとインフラ要件に応じて、自律的にモデルホスティング環境を選択することができます。

-

Orq.aiは、LLM運用自動化のライフサイクル全体を網羅するプラットフォームであり、AIエージェントの設計、デプロイメント、モニタリング、パフォーマンスの最適化まで統合的に管理します。 また、LangfuseやLangSmithが主に「観察」に焦点を当てているのに対し、Orq.aiはエンドツーエンドのAIシステムの構築と運用に特化した構造で設計されています。

-

Orq.ai Studioは、チームがLLM運用自動化の主要なワークフローを処理するための強力なツールです。 これにより、モデルの学習、評価、デプロイメント、モニタリングなど、生成型AIの全プロセスを一元管理することができます。

⚠ 情報に誤りや不足がある場合は、以下のボタンをクリックしてお知らせください。迅速に確認し、反映いたします。